第8个得到"长乐上品十三水其实始终都有挂!"其实是真的有挂(2020有挂版)

你好;长乐上品十三水这款游戏是可以开挂的,确实是有挂的,详情了解加微信【136704302】近日,苹果新款 Mac Studio 和 Mac Pro 都搭载了最新的 M2 Ultra 芯片,这款芯片已经现身 Geekbench 5 跑分平台,展示其相比于 M1 Ultra 芯片的单核和多核性能提升。不过,由于测试没有使用最新的 Geekbench 6 版本,所以这些数据可能会有一些偏差。

一、长乐上品十三水AI软件牌型概率发牌机制”必胜“技巧

1.请看内容:德州长乐上品十三水辅助工具总共10种有所不同的脚本,每种透明挂都有吧相同的辅助概率再次出现。的或,同花顺是极高牌型,出现概率更加低。

2.分析什么内容:数学扑克软件换算,这个可以得出各个长乐上品十三水辅助软件牌型的出现概率。德州微扑克解说的牌型概率对于玩家决策和策略本身重要意义。

3.实例测试:摘录数学家的扑克规律研究结果,展示更多完全不同牌型的概率换算和长乐上品十三水插件结果。

二、长乐上品十三水ai软件购买方法通过(外挂软件透明挂辅助器脚本插件工具)揭秘安装详细教程

;科技透明挂软件辅助器(有挂咨询 136704302)一、什么是游戏挂?

1.打开手机桌面微信APP,进入微信主页。

2.下拉微信主页,找到长乐上品十三水。注意:没有小程序利用的,可在上方搜索小程序。

3.点击进入乐棋海南麻将小程序,选择右上角商城,点击打开。

4.选择道具,找到防作 弊卡,点击耗损10颗钻石购买即可知道手机麻将别人用挂没。

二、游戏挂介绍?

游戏(英文: Game)是所有哺乳类动物,特别是灵长类动物学习生存的第一步。它是一种基于物质需求满足之上的,在一些特定时间、空间范围内遵循某种特定规则的,追求精神世界需求满足的社会行为方式,但同时这种行为方式也是哺乳类动物或者灵长类动物所需的一种降压减排的方式,不管是在出生幼年期,或者发育期,成熟期都会需要的一种行为方式。

合理适度的游戏允许人类在模拟环境下挑战和克服障碍,可以帮助人类开发智力、锻炼思维和反应能力、训练技能、培养规则意识等,但大多游戏对人于实际生活中的进步作用非常有限。

按游戏的载体区分,游戏可分为电子游戏和非电子游戏,游戏种类还有团体性游戏,桌面游戏以及野外生存游戏等。

三、游戏挂怎么操作?

操作使用教程:

1.您好:长乐上品十三水这款游戏可以开挂的,确实是有挂的,通过添加微信客服(136704302)安装这个软件.打开.

2.在"设置DD辅助功能DD微信麻将开挂工具"里.点击"开启".

3.打开工具.在"设置DD新消息提醒"里.前两个选项"设置"和"连接软件"均勾选"开启".(好多人就是这一步忘记做了)

4.打开某一个微信组.点击右上角.往下拉."消息免打扰"选项.勾选"关闭".(也就是要把"群消息的提示保持在开启"的状态.这样才能触系统发底层接口.)

5.保持手机不处关屏的状态.

6.如果你还没有成功.首先确认你是智能手机(苹果安卓均可).其次需要你的微信升级到新版本.

四、游戏挂结论?

亲,长乐上品十三水可以开挂,通过添加客服微信安装这个软件.打开.

2.在"设置DD辅助功能DD微信麻将辅助工具"里.点击"开启".

3.打开工具.在"设置DD新消息提醒"里.前两个选项"设置"和"连接软件"均勾选"开启".(好多人就是这一步忘记做了)

4.打开某一个微信组.点击右上角.往下拉."消息免打扰"选项.勾选"关闭".(也就是要把"群消息的提示保持在开启"的状态.这样才能触系统发底层接口.)

5.保持手机不处关屏的状态.

6.如果你还没有成功.首先确认你是智能手机(苹果安卓均可).其次需要你的微信升级到新版本.

五、第8个得到"长乐上品十三水其实始终都有挂!"其实是真的有挂(2020有挂版);无需打开直接搜索136704302(微信)

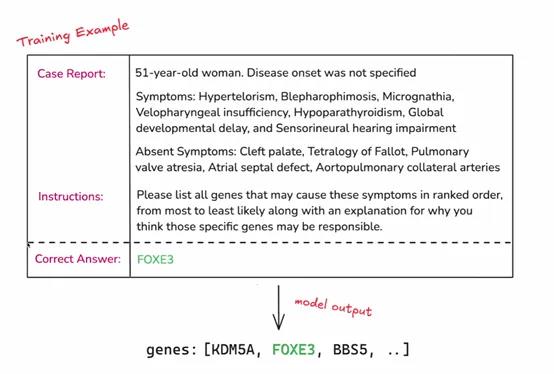

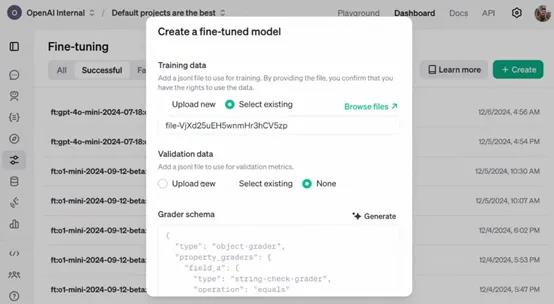

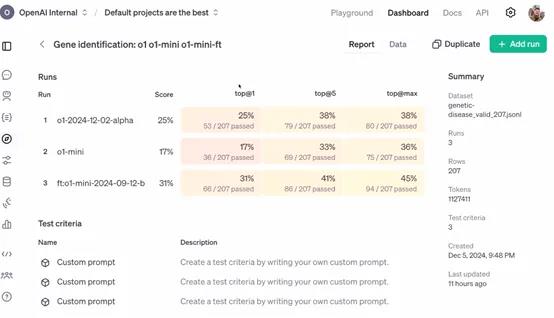

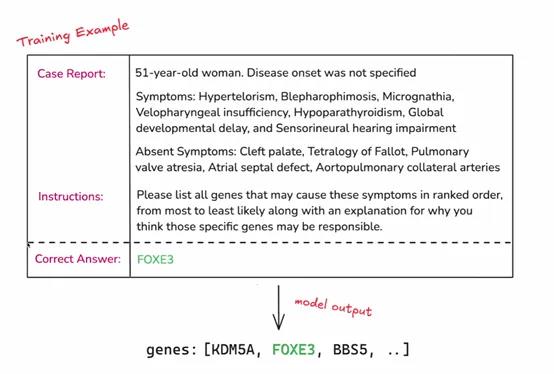

今天凌晨两点,OpenAI开启了12天技术分享直播,发布了最新“强化微调”(Reinforcement Fine-Tuning)计划。

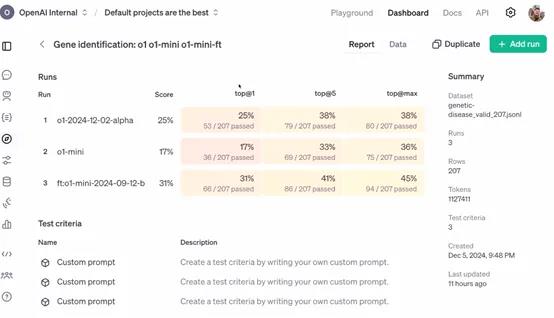

与传统的微调相比,强化微调可以让开发者使用经过微调的更强专家大模型(例如,GPT-4o、o1),来开发适用于金融、法律、医疗、科研等不同领域的AI助手。

简单来说,这是一种深度定制技术,开发者可利用数十到数千个高质量任务,参照提供的参考答案对模型响应评分,让模型学习如何就类似问题推理,提高其在特定领域任务上的准确性和工作效率。

申请API:https://openai.com/form/rft-research-program/

在许多行业,虽然一些专家具有深厚的专业知识和丰富的经验,但在处理大规模数据和复杂任务时,可能会受到时间和精力的限制。

例如,在法律领域,律师需要处理大量的法律条文和案例,虽然他们能够凭借专业知识进行分析,但借助经过强化微调的 AI 模型,可以更快速地检索相关案例、进行初步的法律条文匹配和分析,为律师提供决策参考,提高工作效率。

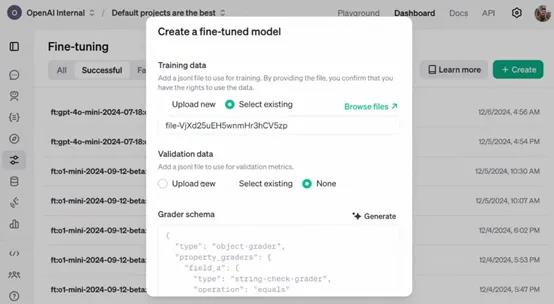

OpenAI表示,作为研究计划的一部分,参与者将能够访问处于alpha 阶段的强化微调 API。开发者可以利用该 API 将自己领域特定的任务数据输入到模型中,进行强化微调的实验和应用。

例如,一家医疗研究机构可以将大量的临床病例数据通过 API 输入到模型中,对模型进行医疗诊断任务的强化微调,使其能够更好地理解和处理各种疾病症状与诊断之间的关系。

目前该 API 仍处于开发阶段,尚未公开发布。所以,参与者在使用 API 过程中遇到的问题、对 API 功能的建议以及在特定任务上的微调效果等反馈,对于 OpenAI 改进 API 具有至关重要的作用。

例如,企业在使用 API 对其财务风险评估模型进行微调时,如果发现模型在处理某些特殊财务数据结构时出现错误或不准确的情况,将这些信息反馈给 OpenAI,能够帮助其优化 API 中的数据处理算法和模型参数调整策略,从而使 API 更加完善,为后续的公开发布做好准备。

强化微调简单介绍

强化微调是一种在机器学习和深度学习领域,特别是在大模型微调中使用的技术。这项技术融合了强化学习的原理,以此来优化模型的性能。微调是在预训练模型的基础上进行的,预训练模型已经在大量数据上训练过,学习到了通用的特征。

通过无监督学习掌握了语言的基本规律,然后在特定任务上进行微调,以适应新的要求。强化学习则关注智能体如何在环境中采取行动以最大化累积奖励,这在机器人训练中尤为重要,智能体通过不断尝试和学习来找到最优策略。

强化微调则是将强化学习的机制引入到微调过程中。在传统微调中,模型参数更新主要基于损失函数,而在强化微调中,会定义一个奖励信号来指导这个过程。

这个奖励信号基于模型在特定任务中的表现,比如在对话系统中,模型生成的回答如果能够引导对话顺利进行并获得好评,就会得到正的奖励。策略优化是利用强化学习中的算法,如策略梯度算法,根据奖励信号来更新模型参数。

在这个过程中,模型就像智能体一样,它的参数调整策略就是需要优化的策略,而奖励信号就是对这个策略的评价。

此外,强化微调还需要平衡探索和利用,即模型既要利用已经学到的知识来稳定获得奖励,又要探索新的参数空间以找到更优的配置。

收集人类反馈数据,通常是关于模型输出质量的比较数据。通过这些反馈训练一个奖励模型,该模型能够对语言模型的输出进行打分,以反映其质量或符合人类期望。